Google DeepMind 提出的一种使用Actor Critic结构, 但是输出的不是行为的概率, 而是具体的行为, 用于连续动作 (continuous action) 的预测.DDPG结合了之前获得成功的DQN结构, 提高了Actor Critic的稳定性和收敛性.

算法 {#算法}

DDPG的算法实际上就是一种Actor Critic,

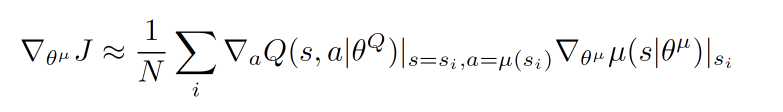

关于Actor部分, 他的参数更新同样会涉及到Critic, 上面是关于Actor参数的更新, 它的前半部分grad[Q]是从Critic来的, 这是在说:这次Actor的动作要怎么移动, 才能获得更大的Q, 而后半部分grad[u]是从Actor来的, 这是在说:Actor要怎么样修改自身参数, 使得Actor更有可能做这个动作. 所以两者合起来就是在说:Actor要朝着更有可能获取大Q的方向修改动作参数了.

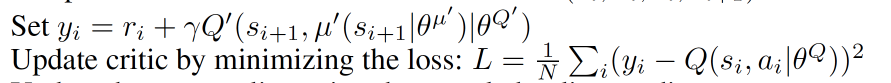

上面这个是关于Critic的更新, 它借鉴了DQN和Double Q learning的方式, 有两个计算Q的神经网络,Q_target中依据下一状态, 用Actor来选择动作, 而这时的Actor也是一个Actor_target(有着 Actor 很久之前的参数). 使用这种方法获得的Q_target能像DQN那样切断相关性, 提高收敛性.

书籍推荐